Avec la montée en puissance des intelligences artificielles, les images générées par l’IA sont de plus en plus achetées sur internet. Largement utilisé par les propagateurs de fausses nouvelles, leur réalisme troublant les rend parfois très difficiles à identifier. Mais il y a des indices…

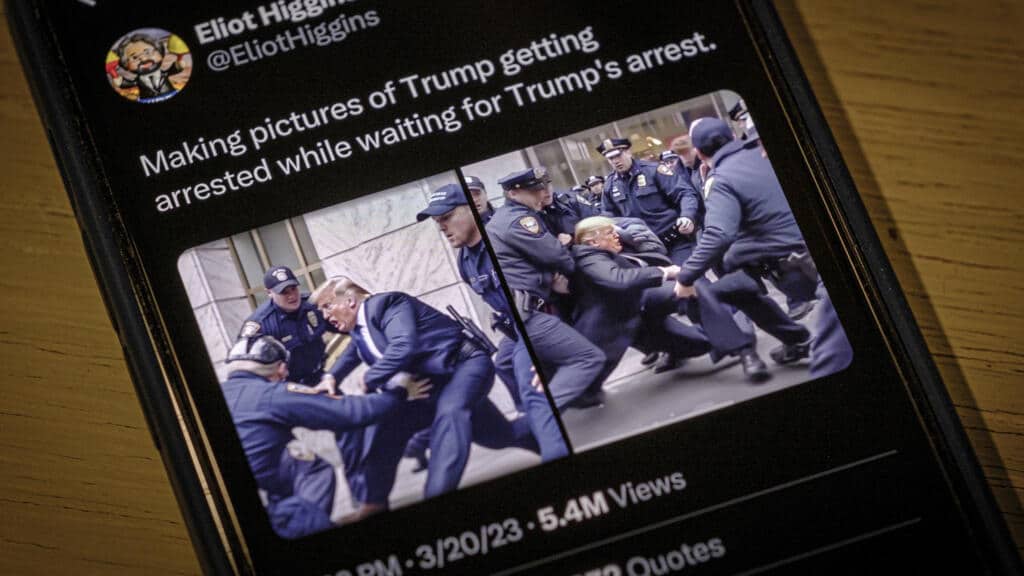

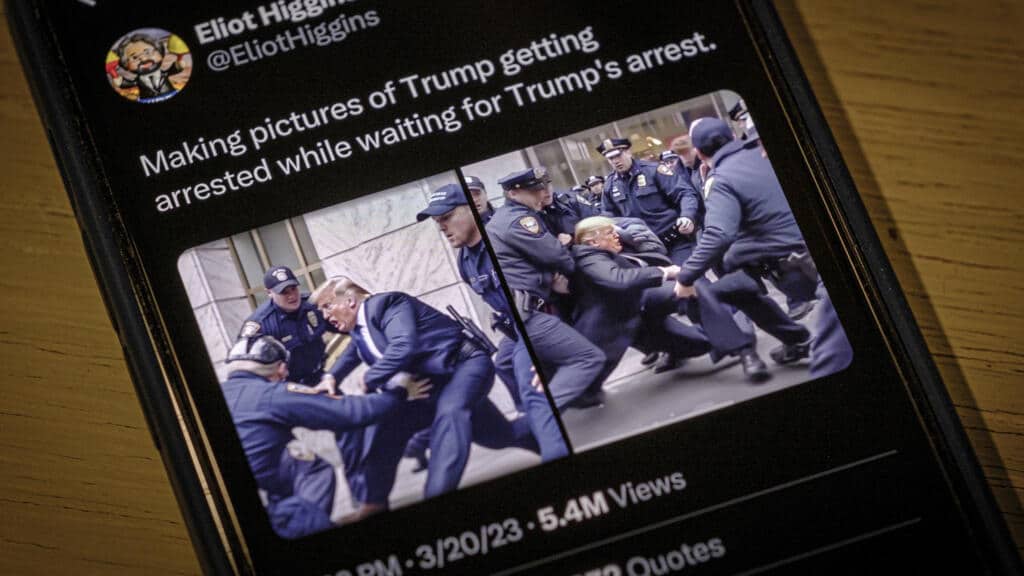

Le pape François en doudoune blancheDonald Trump arrêté par des policiers ou plus récemment un vieil homme le visage ensanglanté interpellé lors d’une manifestation contre la réforme des retraites… Le développement des intelligences artificielles est désormais du pain béni pour les propagateurs de fausses informations – ou de simples plaisantins – qui les utilisent pour produire des images ultra réalistes mais inventées de toutes pièces.

Parmi ces indices, on peut noter l’absence de signes distinctifs des forces de l’ordre français (bandes de couleur, insignes) ou encore l’apparence étrange de la visière visible en haut à gauche de l’image 3/… pic.twitter.com/oWfWjipcUt

— AFP Factuel

(@AfpFactuel) 30 mars 2023

Des logiciels comme Midjourney, DALL-E ou Stable Diffusion sont ainsi capables de générer une infinité de clichés à partir d’une immense base de données sans cesser d’être alimentées par les demandes d’utilisateurs. Ces images qui semblent tout à fait réalistes lors d’un coup d’œil rapide sèment la confusion, tout particulièrement lorsqu’elles sont liées à l’actualité, mais une analyse plus poussée peut – parfois – permettre de les identifier.

Logo et recherche inversée

Pour créer ces images, rien de plus simple. Dans un logiciel comme Midjourney, il suffit de taper dans une barre de recherche une demande écrite pour que soit produite, à partir de millions d’images, une nouvelle image créée, pixel par pixel, par l’intelligence artificielle. Le résultat peut être bluffant de réalisme, mais certaines imperfections peuvent subsister et mettre la puce à l’oreille.

Le premier élément qui peut indiquer qu’une photo a été produite par une intelligence artificielle, c’est la signature que l’on peut trouver dans le coin inférieur droit de l’image. Pour le logiciel DALL-E, il s’agit par exemple d’un rectangle multicolore, ce point de repère peut cependant être supprimé par des gens mal intentionnés en recadrant l’image. Une autre solution est d’effectuer une recherche inversée dans un moteur de recherche en glissant l’image en question dans la barre de recherche pour retrouver ses occurrences passées et retrouver sa source.

S’attacher aux détails

Mais la meilleure façon de repérer une image créée par une intelligence artificielle reste encore d’ouvrir grand les yeux en s’attachant aux détails. Les IA ont par exemple encore énormément de mal à produire des reflets ou des ombres. Le grain de l’image est souvent très particulier et les arrière-plans sont en général très flous et si l’on y retrouve des textes, ils ne veulent rien dire.

« Il faut trouver les incohérences dans les détails. Ce sont souvent des photos qui, à première vue, sont très réalistes, mais quand on les regarde mieux, il y a souvent des problèmes, analyse Lise Kiennemann, journaliste pour le site Les Observateurs de France 24, qui travaille sur ces thématiques. Les textes sont problématiques, car l’IA n’arrive pas bien à les produire. Un autre indice, ce sont les visages en arrière-plan qui sont assez mal faits. Ce sont des visages flous, pas tout à fait formés. »

En s’attardant sur les fausses photos de l’arrestation de Donald Trump partagées par le fondateur du site Bellingcat, Eliot Higgins, on s’aperçoit par exemple que ce qui est inscrit sur les casquettes des policiers ne veut rien dire, que l’ex-président américain porte une matraque et qu’il y a une incohérence au niveau de ses membres inférieurs puisqu’ il semble disposer de trois jambes. Autant d’indices qui permettent de dire qu’il s’agit d’images générées par une IA, d’autant plus qu’au moment de leur publication, Donald Trump n’avait toujours pas été arrêté.

Les générateurs d’images créent également souvent des asymétries avec des visages disproportionnés, avec des oreilles à des hauteurs différentes. Ils ont par ailleurs du mal à reproduire les dents, les cheveux mais aussi les doigts. Début février, des images de femmes enlaçant des policiers lors d’une manifestation contre la réforme des retraites sont devenues virales, mais elles ont rapidement été détectées étant comme fausses puisque sur l’une d’entre elles, le policier avait… six doigts.

Vers la perfection

Les intelligences artificielles restent donc encore perfectibles mais à la vitesse à laquelle elles évoluent, il pourrait très rapidement devenir impossible de différencier des images générées par l’IA d’images belles et bien réelles. « Midjourney, ils sont à la V5. La différence entre la V1 et la V5 en quelques mois, c’est absolument bluffant. On peut penser que dans quelques années peut-être, mais je pense plutôt quelques mois, on ne saura plus faire la différence », explique Guillaume Brossard, spécialiste de la désinformation et fondateur du site Hoaxbuster. Midjourney est d’ailleurs lui-même dépassé par l’ampleur du phénomène puisque le site a annoncé le 30 mars que, croulant sous « une demande extraordinaire et un abus des essais », il suspendait sa version d’essai gratuite.

Corollaire de cette évolution, des images sèment le doute alors qu’elles sont pourtant bien réelles. La photo d’une jeune femme interpellée à Paris en marge des manifestations a par exemple tout de suite été identifiée comme la création d’une intelligence artificielle par des internautes, jusqu’à ce que l’auteur de la photo confirme qu’elle était bien réelle et que d’autres images de l’interpellation, prises depuis un autre angle, viennent corroborer ses dires.

Ca devient vraiment fascinant et très désinvolte à la fois. On entre déjà dans une ère d’hyper-méfiance (ou d’hyper mauvaise foi ?) où toute photographie à laquelle on refuse de croire est diffusée par une IA. Les biais de confirmation vont exploser. pic.twitter.com/3lmVMgCoGy

—Guillaume Champeau (@gchampeau) 30 mars 2023

« On peut croire que des images réelles sont en réalité de l’IA et on peut croire que des images de l’IA sont réelles, donc les frontières sont déjà très floues et elles vont encore s’effacer un peu plus dans les mois à venir, analyse Guillaume Brossard. Mais il y a une chose que les IA savent pas faire et qu’elles ne sont pas près de savoir faire, je pense, c’est de reproduire une scène sous plusieurs angles et ça, c’est un très bon indice. »

La désinformation dans une nouvelle ère

Dès lors, retrouver des images d’un événement pris sous différents angles est un bon moyen de vérifier si une image est bien réelle. Des outils comme l’application Hugging Face permettent aussi de déterminer la probabilité qu’une image soit issue d’une IA, mais leur fiabilité reste relative et cela ne devrait pas aller en s’arrangeant.

Face à ces nouvelles technologies qui vont faire rentrer la désinformation dans une nouvelle ère, le meilleur comportement pour se protéger reste donc de constamment s’interroger sur les images que l’on peut voir, en particulier celles qui vont chercher à toucher la corde sensible de nos émotions en nous permettant de nous scandaliser. Selon Guillaume Brossard, c’est l’un des principaux ressorts de la désinformation et « dès lors qu’une image génère une émotion, il faut impérativement se poser la question de savoir si elle n’est pas potentiellement trafiquée d’une manière ou d’une autre ».

Avec l’amélioration fulgurante des intelligences artificielles, pas sûr cependant que cela soit suffisant pour lutter contre l’influence croissante des Fdes nouvelles. « Aujourd’hui, les gens ne croient qu’à ce dont ils ont envie de croire. Ils s’en foutent que ce qu’on leur montre soit vrai ou pas et c’est bien le problème, déplore le fondateur de Hoaxbuster. On est un peu dans la suite de ce que Trump avait un peu théorisé avec les vérités alternatives et l’ère de la post-vérité. On est en plein dedans et il va falloir apprendre à vivre avec. »

Pour contrer cette menace, l’éducation aux médias reste un levier indispensable. Des voix s’élèvent également pour réclamer une « mise en pause » du développement des intelligences artificielles. Des personnalités comme Elon Musk, le patron de Tesla, ou Steve Wozniack, cofondateur d’Apple, ont écrit une lettre ouverte pour demander l’ouverture d’un moratoire de six mois sur les IA qu’ils ajoutent comme un « enjeu existentiel » pour l’humanité. Une position partagée par Guillaume Brossard : « Il faudrait qu’il y ait un moratoire, un peu comme ce qui a pu être fait à une époque pour les armes nucléaires. Que l’humanité se pose un peu et décide de rajouter une sorte d’empreinte qui atteste à 100% qu’un fichier est issu d’une intelligence artificielle ». Mais l’expert le concède, « compte tenu des enjeux de la désinformation aujourd’hui, ce n’est vraiment pas gagné. »

Bibliographie :

La France contre les Robots.,Fiche de l’ouvrage. A emprunter en bibliothèque.

Le crocodile et le scorpion.,Présentation de l’ouvrage.

Renaissance et Réforme/Bibliographie.,Pour en savoir plus.

(@AfpFactuel)

(@AfpFactuel)